사랑하는 나의 최애 노트앱 옵시디언 with LLM Copilot

1. 세줄요약

01. Obisidian(옵시디언)에 LLM을 연결했다.

02. Local LLM, API를 통한 LLM이 다양하니 알맞게 쓰면 되겠다.

03. 메모광이라면 정말 효율적인 툴이다.

2. 내용

(1) 노트앱 유목민에서 이제는 정착민으로

저의 최애 옵시디언을 사용한지 언 1년이 다되어갑니다. S메모, 스티커메모, 에버노트, 노션, 굿노트, 갤럭시 메모, 아이폰 메모를 써왔죠.

돌이켜보면 다 조금씩 잘썼는데 지금은 옵시디언에 정착했습니다.

옵시디언의 장점은 참 많지만 제게 중요한 것들을 나열해보면

1. 로컬에 저장할 수 있다. (iOS의 경우엔 iCloud를 사용할 수 있다.)

2. 프로그램이 가볍다.

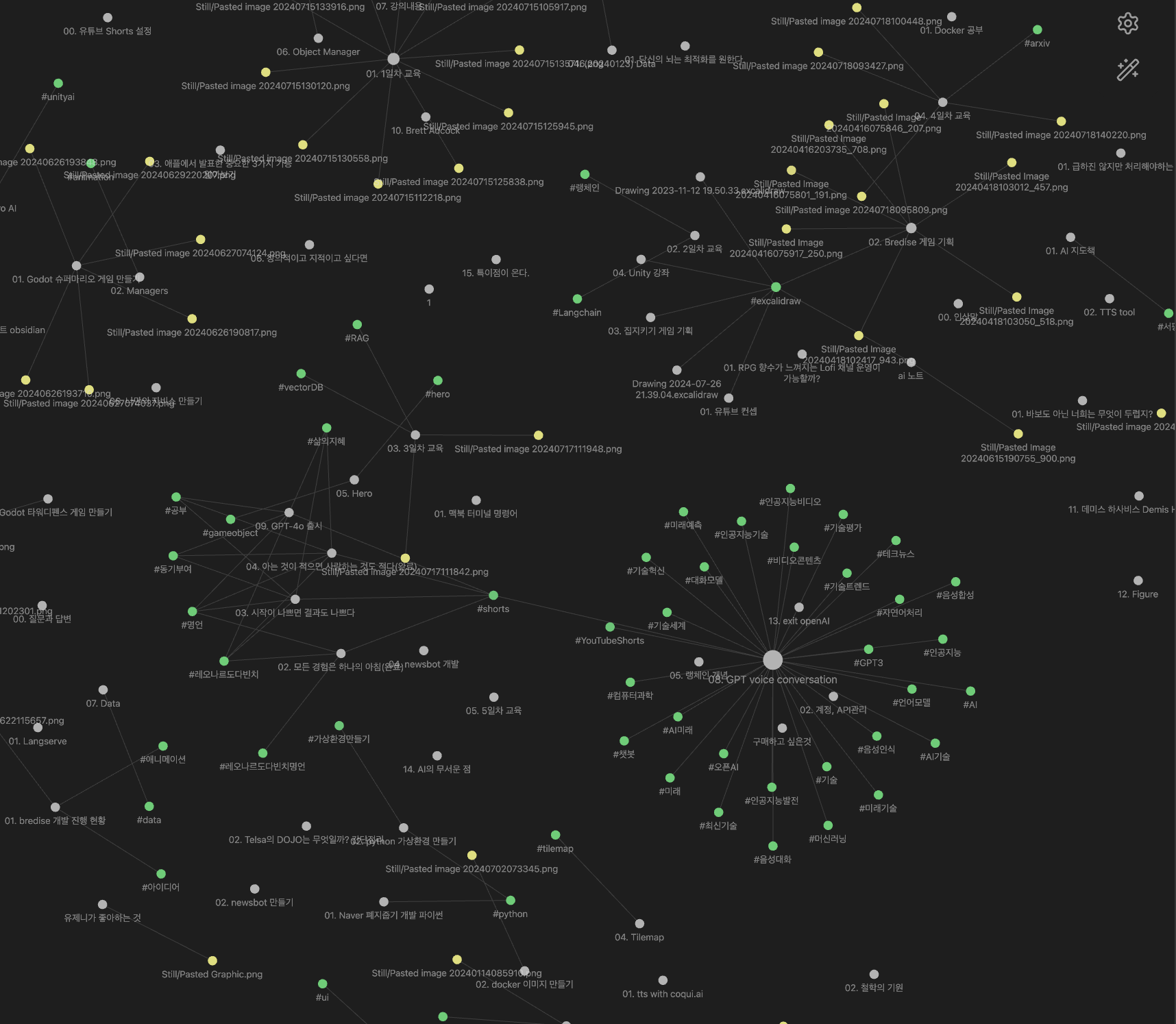

3. graph view를 사용할 수 있다. (나의 두번째 뇌)

4. (강조) 커뮤니티 플러그인이 있다.

graph view는 태그로 정리하다보면 제가 어떤 분야에 대해 관심이 있고 정리를 하는지 한 눈에 시각화하여 볼 수 있습니다.

특히 커뮤니티 플러그인은 훌륭한 전세계 개발자분들이 옵시디언의 좋은 기능들을 넣어주셔서 알맞게 잘 쓸 수 있습니다.

(2) 옵시디언의 강력한 기능...커뮤니티 플러그인! Copilot 플러그인을 사용해보자!

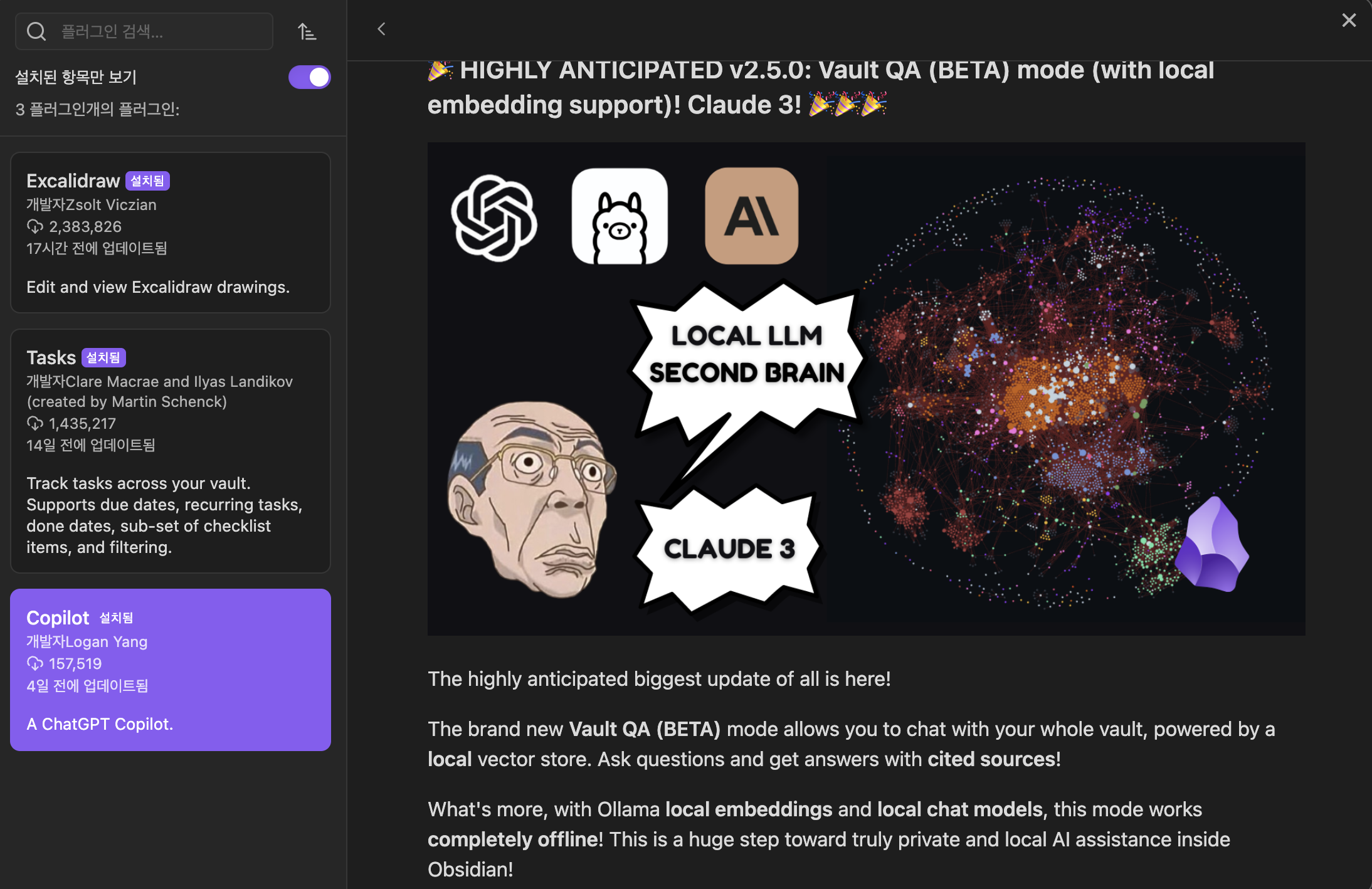

커뮤니티 플러그인을 살펴보던중 copilot을 발견했습니다. obsidian과 LLM을 연결하면 어떤 기능이 있을까? 확인해봤습니다.

나의 Vault에 있는 Vault QA가 가능하다는 글이 있네요...흥미롭습니다!!

(3) API로 LLM을 사용할 수 있다!

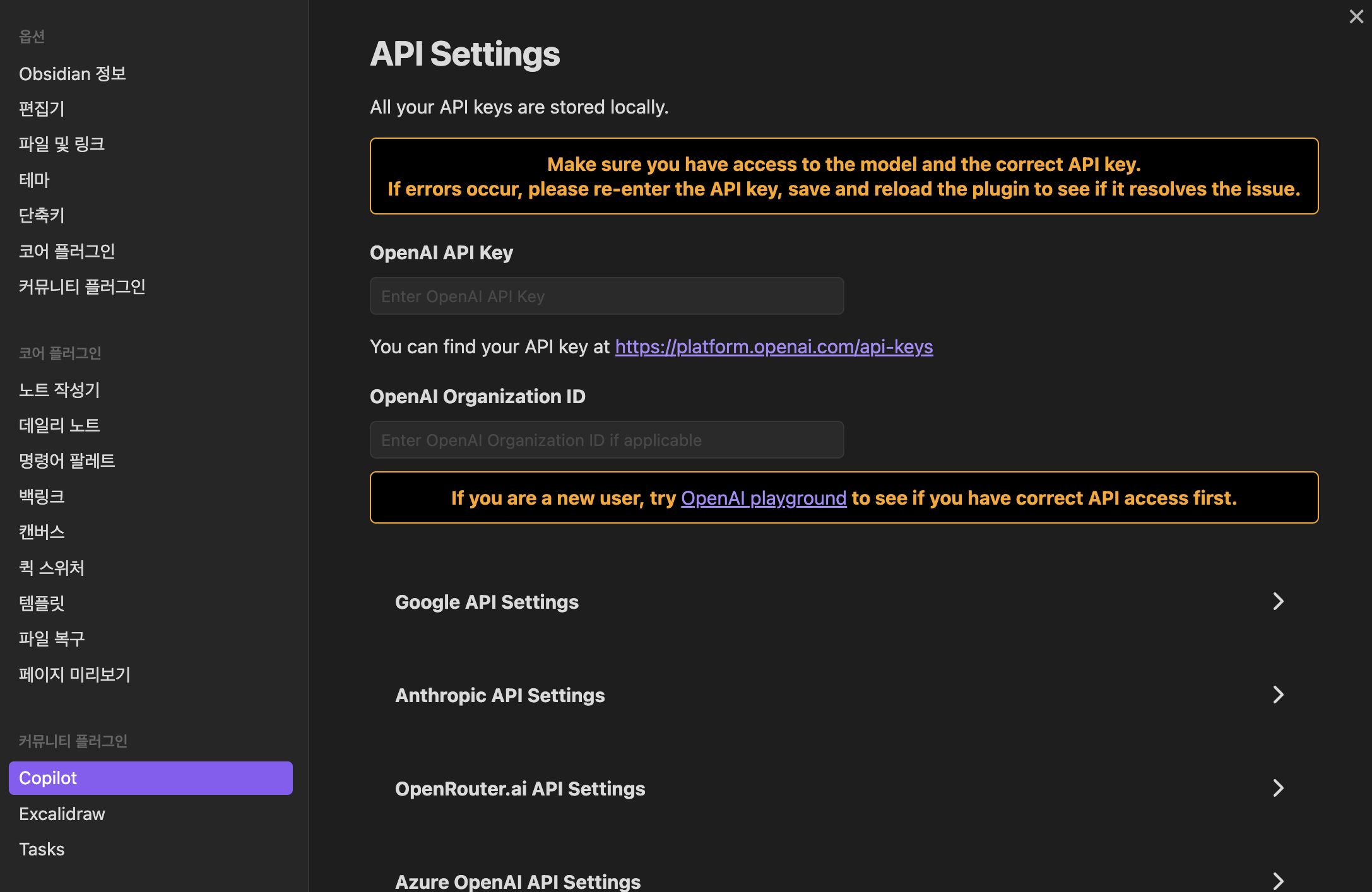

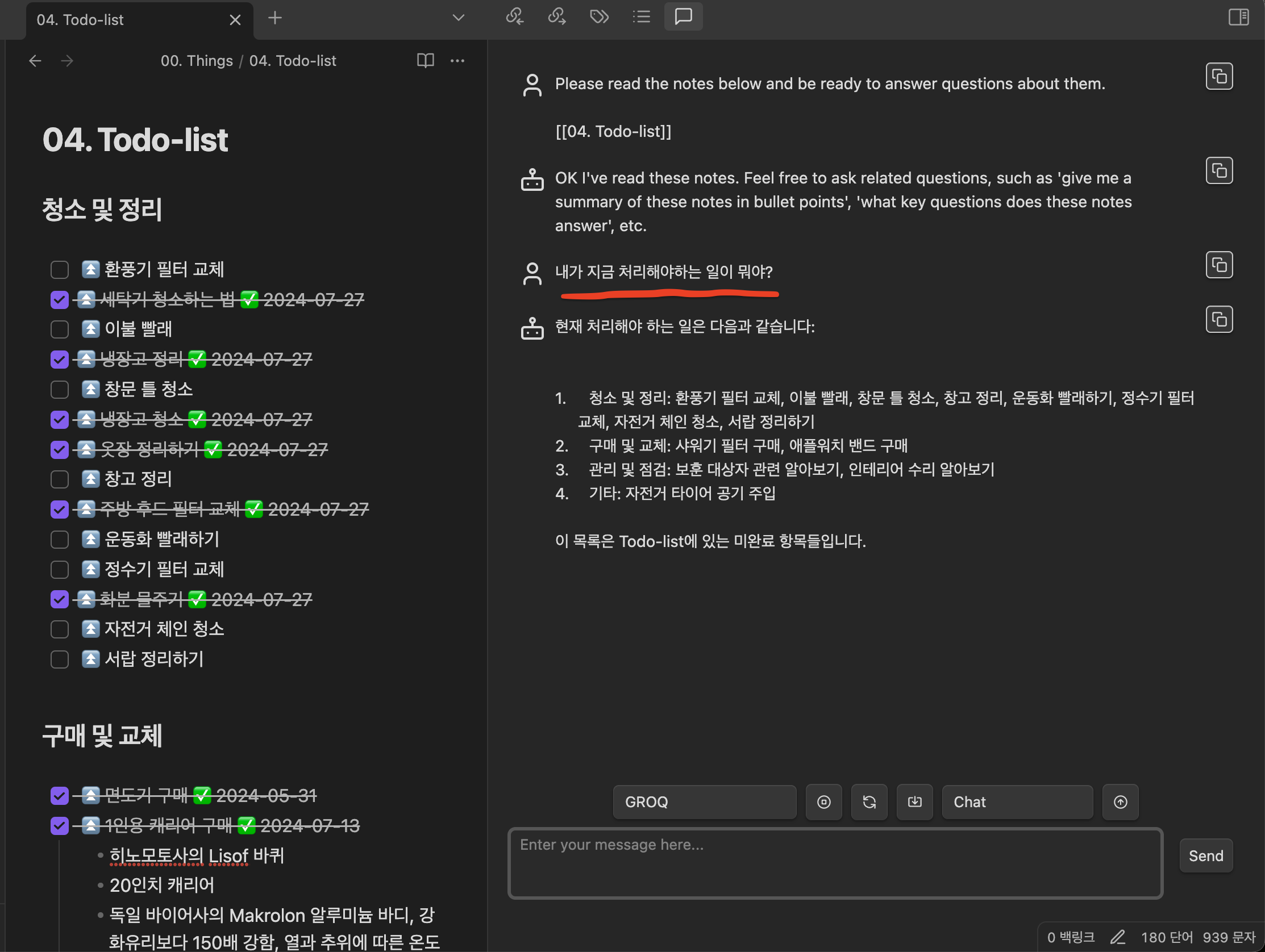

커뮤니티 플러그인을 확인하면 다양한 API key를 setting할 수 있는 화면이 있습니다. OpenAI, Google, Anthropic, OpenRouter, Groq 등이 있습니다. 그 중 저는 Groq에 API키 값을 넣고 저장을 했습니다.

그러면 Groq을 선택하고 사용해보겠습니다.

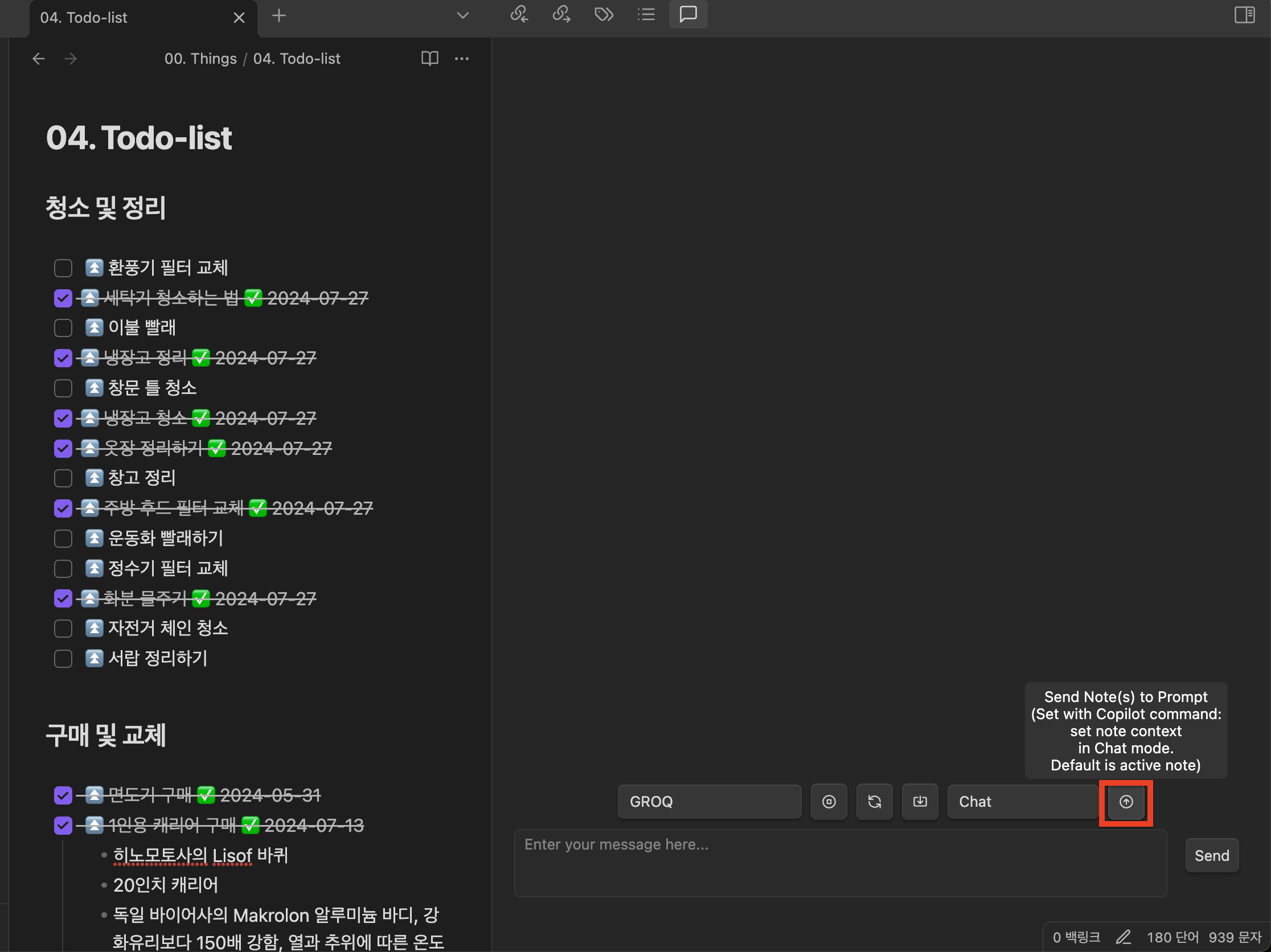

빨간버튼을 클릭하면 현재 보고 있는 note의 값을 LLM에 전달합니다.

지금 제가 처리해야하는 일들이 무엇이 남았는지 물어보니 Todolist에 처리한 일을 제외한 나머지 처리할 일들을 정리해주는 것을 확인할 수 있었습니다. 훌륭합니다.

(4) API가 불안하다면 Local LLM을 사용할 수 있다!

그런데 여기서 이런 질문을 하실 수 있을 것 같습니다. OpenAI를 믿을 수 있냐? Groq이 LPU(Language Processing Unit) 빌려주면서 내 데이터를 가져가는 거 아니냐? 그러게요... 그렇게 말씀하시면 저는 할 말이 없습니다...

그래서 대안으로 LM studio나 Ollama를 통해 Hugging face에서 Local 모델을 받으셔서 내 자원을 갖고 사용하면 됩니다.

Ollama를 설치하는 법은 아래 포스트에서 소개했으니까 참조해주세요!

https://idealist.tistory.com/153

Ollama의 개념과 설치 및 사용방법 GGUF 허깅페이스 Huggingface

1. 세줄요약01. Ollama를 설치하여 LLM모델을 불러왔다.02. Ollama Pull 명령어를 통해 모델을 불러온다.03. GGUF파일 형태인 양자화 모델도 Modelfile을 통해 불러올 수 있다. 2. 내용(1) Ollama가 뭔가요?2022년

idealist.tistory.com

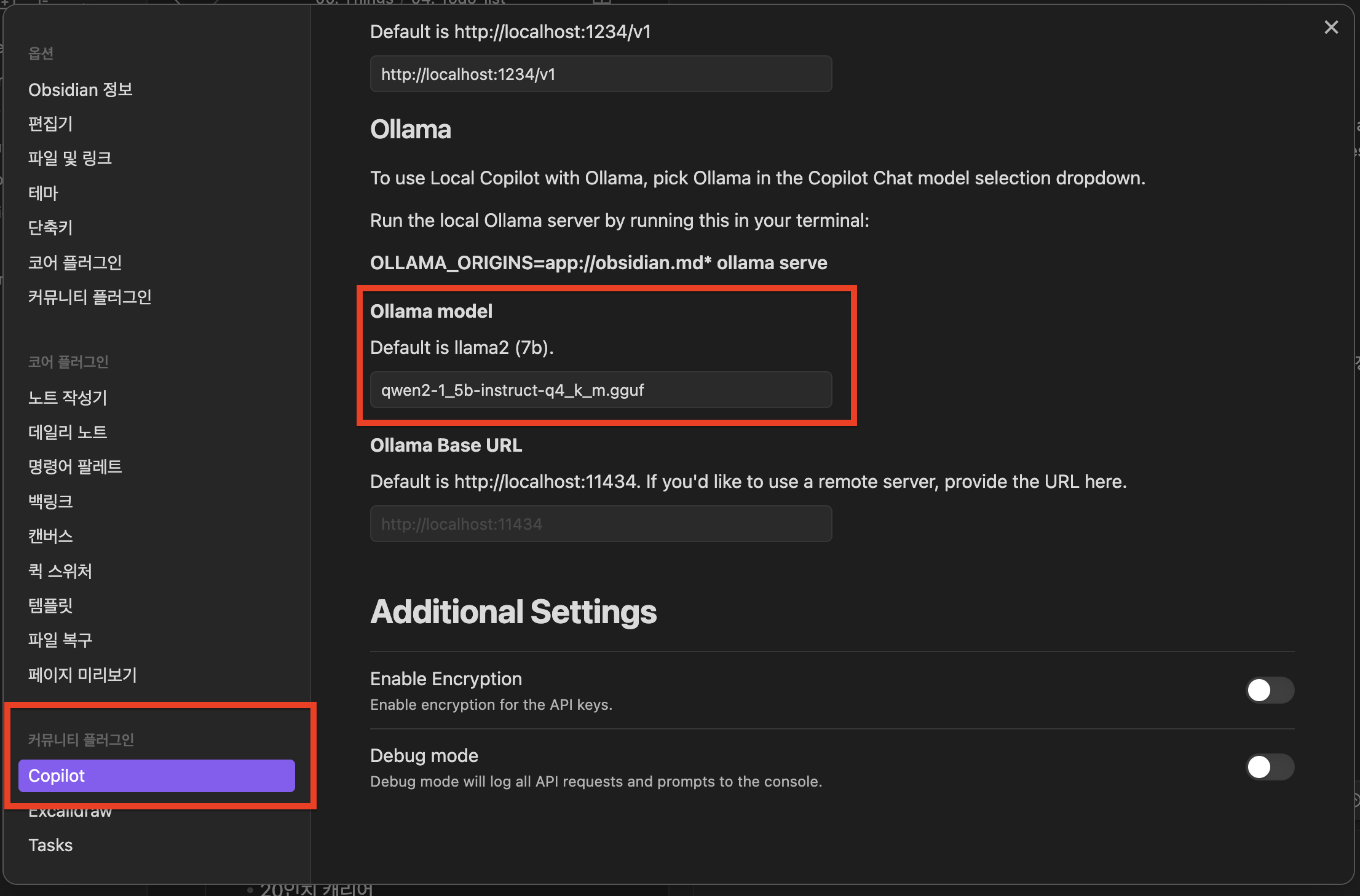

저는 지금 맥북프로 M1 기준으로 설명을 드리고 있습니다. Llama-7B나 Qwen2-7B를 사용하려고 했는데 M1 CPU를 사용하기 때문에 1.5B가 제일 잘 맞더라구요. 그래서 qwen2-1_5b-instruct-q4_k_m.gguf를 다운로드 받아서 Ollama 서버를 올렸습니다.

먼저 옵시디언 커뮤니티 플러그인에서 Copilot을 클릭하신다음에 Ollama 모델을 명시해주시구요.

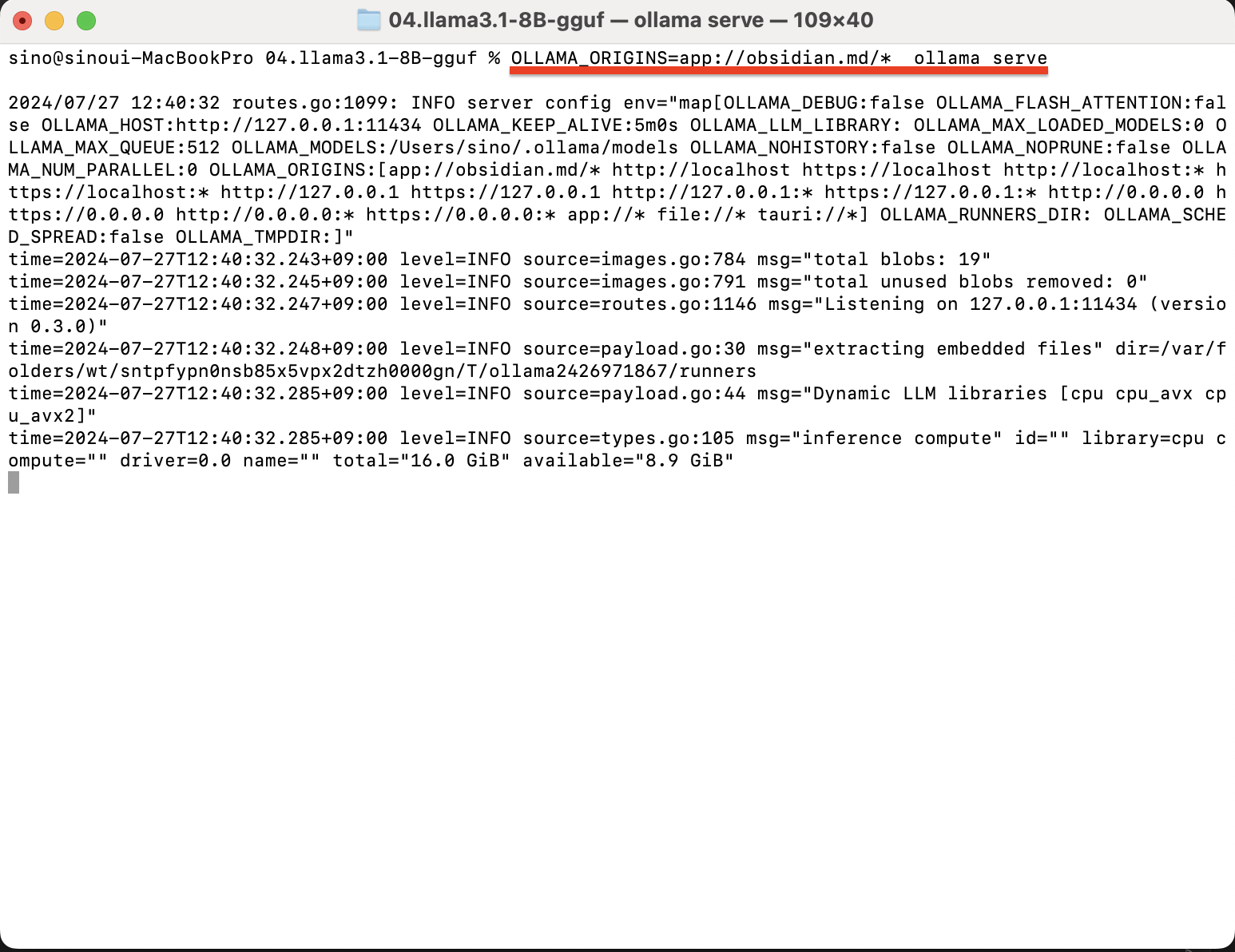

OLLAMA_ORIGINS=app://obsidian.md/* ollama serve터미널에서 shell명령어를 입력하시면

Ollama 서버가 실행된 것을 확인할 수 있습니다.

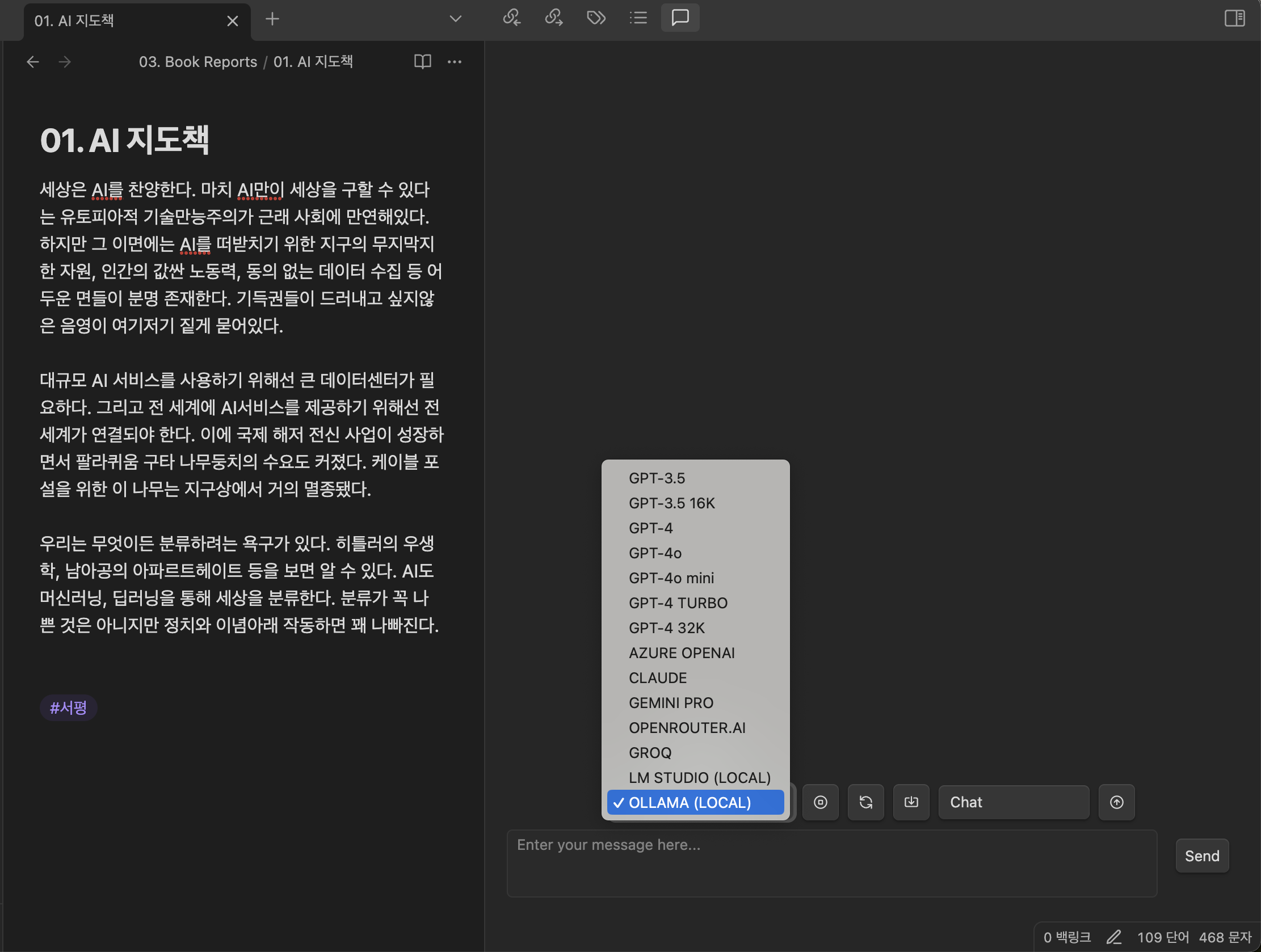

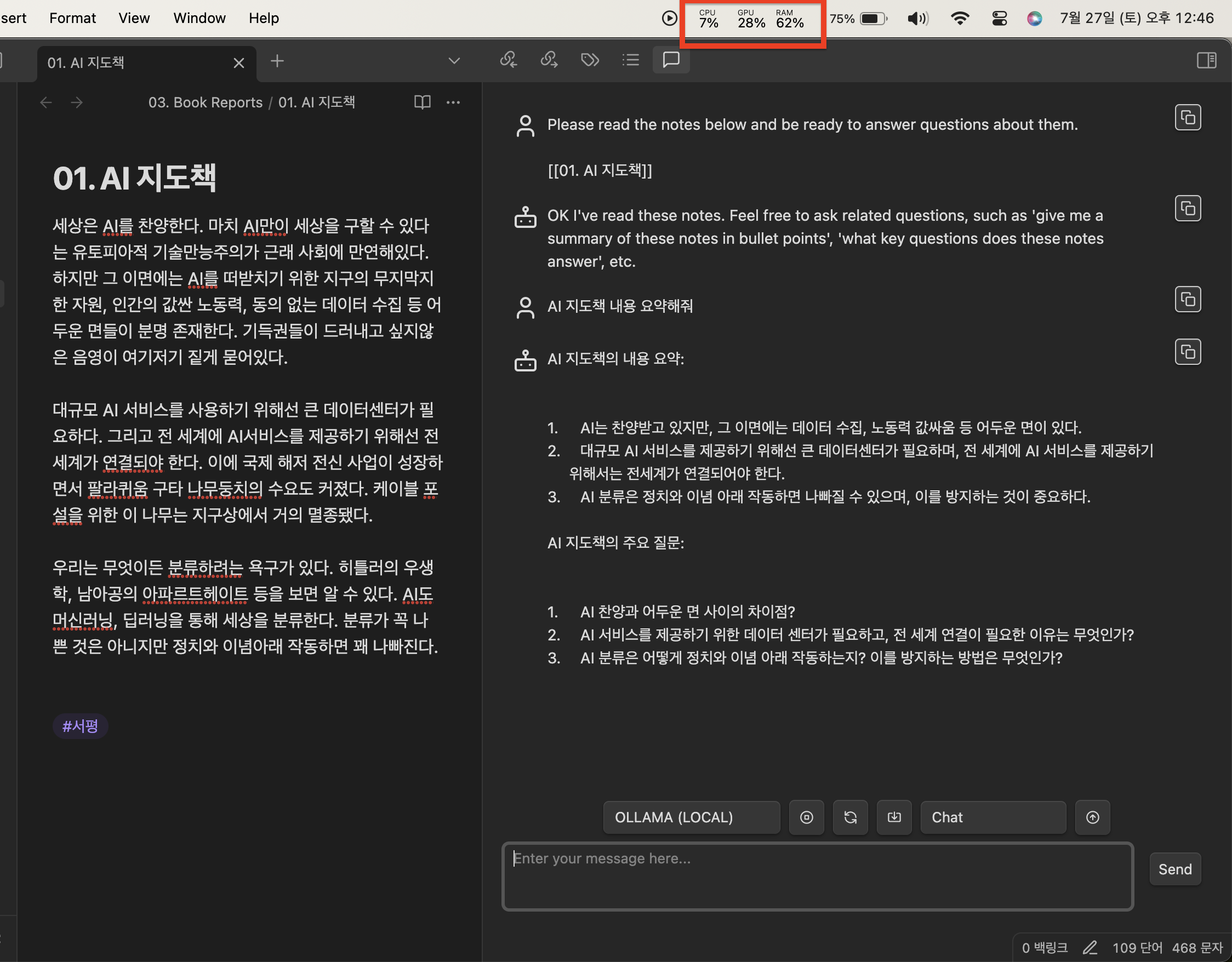

위에 API로 설정한다음에 노트를 불러와서 질문하는 동일한 방법으로 AI지도책에 대한 내용을 질문해보겠습니다.

그림에서 보시는 것처럼 제가 작성한 AI지도책에 대해서 요약해달라고 요청을 하니 잘 정리해준 것을 확인할 수 있습니다.

qwen2 1.5B 양자화 모델을 구동했음에도 빨간박스에 CPU값을 실시간으로 보니 88%까지 올라간 것을 볼 수 있었습니다. 맥북 M1은 팬소리가 잘 나지 않는데 팬소음과 발열이 꽤심했습니다;;

3. 마치며

이번 시간은 저의 최애 노트앱 옵시디언에 LLM을 플러그인으로 연결하는 작업을 해봤습니다.

확실히 외부 GPU 자원을 사용하는게 정말 빠르고 좋습니다. 저는 그래서 최대한 Groq을 사용하려고 합니다.

갖고 계신 자원이 고성능GPU라면 로컬에서 구동하는 것을 추천드리고, 저같이 맥북 유저나 저성능자원을 갖고 계신분들은 AI 상용서비스를 사용하는게 좋을듯 합니다.

질문이 있으시면 언제든 댓글 남겨주세요! 답변드리겠습니다. 같이 공부합시다^^

이 글을 보는 모든 분들 오늘 하루가 행복하시길 바랍니다.

감사합니다.